KI-Lösungen für Unternehmen: Wenn die Infrastruktur über den Erfolg entscheidet

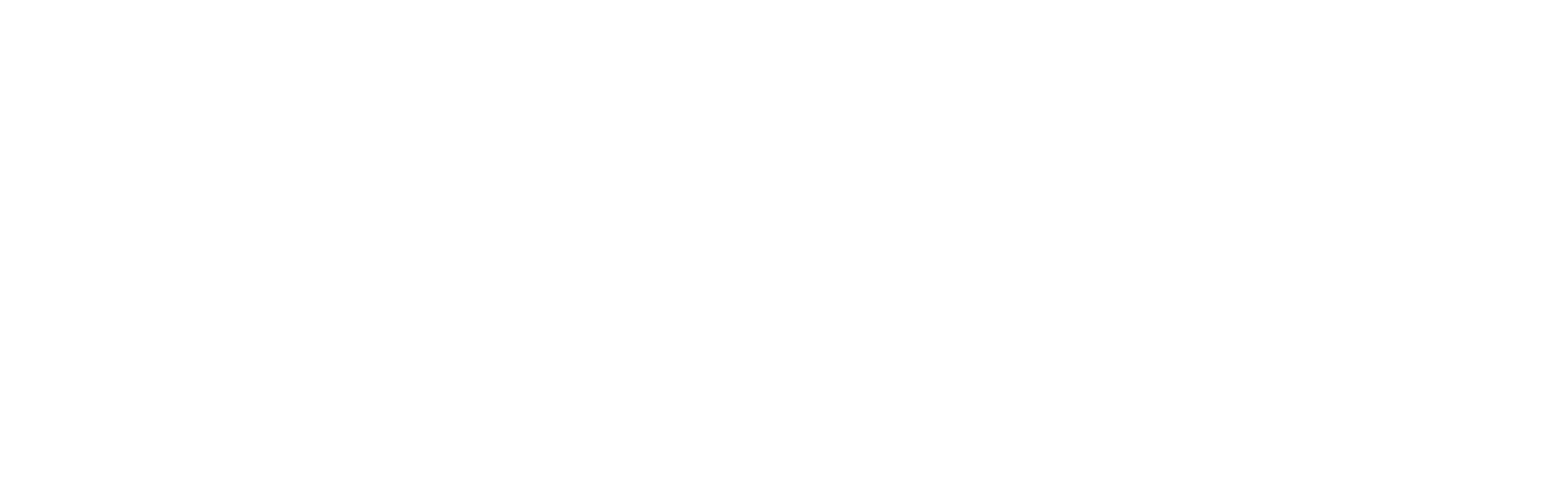

Künstliche Intelligenz gilt als wichtiger Hebel für mehr Produktivität. In vielen mittelständischen Unternehmen sind KI-Lösungen deshalb längst im Einsatz – häufig in Form operativer Systeme, die Prozesse analysieren oder Entscheidungen unterstützen. Allerdings meist noch als Pilotprojekt. Über den Langfristerfolg entscheidet jedoch selten das gewählte KI-Modell, sondern ob die KI-Infrastruktur des Unternehmens einen stabilen, skalierbaren und sicheren Regelbetrieb gewährleistet. Was verhindert, dass KI den Schritt vom Piloten in den produktiven Betrieb schafft? Und wie lässt sich dieser Übergang strukturiert gestalten?

Vom Proof of Concept zum Dauerbetrieb: Die Infrastruktur als Engpass

Wie weit ist KI tatsächlich in den Betrieben angekommen? Zahlen aus dem Frühjahr 2025 zeigen ein gemischtes Bild: Rund 40 % nutzten Künstliche Intelligenz bereits aktiv, vielen anderen stand der Einstieg noch bevor.

| Status quo: KI-Nutzung im deutschen Mittelstand (Frühjahr 2025)1 | |

|---|---|

| Kategorie | Anteil der Unternehmen |

| Unternehmen, die KI bereits einsetzen | 40 % |

| Unternehmen, die KI in naher Zukunft einführen wollen | 21 % |

| Unternehmen ohne KI Nutzung | 39 % |

Quelle:

1 Hochschule Karlsruhe vom Oktober 2025 (Erhebungszeitraum: Mitte März bis Mitte Mai 2025)

Anforderungen für den produktiven KI-Betrieb

In der Testphase steht vor allem die grundsätzliche Funktionsfähigkeit einer KI-Lösung im Mittelpunkt. Sobald sie jedoch dauerhaft eingesetzt werden soll, steigen die Anforderungen deutlich: Verfügbarkeit, Reproduzierbarkeit, Integration in bestehende Systeme und klare Verantwortlichkeiten werden unverzichtbar – gleichgültig, ob es um Fertigungslinien, Serviceprozesse, Handelssysteme oder kliniknahe Abläufe geht. Spätestens im dauerhaften Betrieb geraten KI-Lösungen für Unternehmen an ihre Grenzen. Die KI-Implementierung scheitert oftmals nicht am Modell, sondern daran, dass sie nicht auf den Einsatz im Tagesgeschäft ausgelegt ist. Die Skalierbarkeit, Wartbarkeit und Absicherung müssen deshalb von Anfang an in der Architektur berücksichtigt werden.

Wenn die IT-Landschaft zum Flaschenhals wird

Die Herausforderung bei KI-Lösungen für Unternehmen liegt nicht nur in der passenden Auswahl der Anwendungen, sondern vor allem in der Einbettung der Infrastruktur. Viele mittelständische Betriebe verfügen über Systemlandschaften, die nicht für KI-Workloads im täglichen Einsatz ausgelegt sind. Gleichzeitig steigen die Erwartungen an Antwortzeiten, Verfügbarkeit und die Integration in bestehende Anwendungen. Auch Support, Monitoring und Wartungsfähigkeit gewinnen im Regelbetrieb deutlich an Bedeutung.

Fehlen diese Voraussetzungen, lässt sich die Lösung nicht produktiv betreiben – unabhängig davon, wie viel Einspar- oder Gewinnpotenzial die KI verspricht. Besonders in geschäftskritischen Prozessen zeigt sich das deutlich: Fällt eine KI-Komponente aus, steht im Zweifel gleich eine ganze Produktionslinie still, eine Servicekette kommt ins Stocken oder Bestellungen und Anfragen bleiben unbearbeitet.

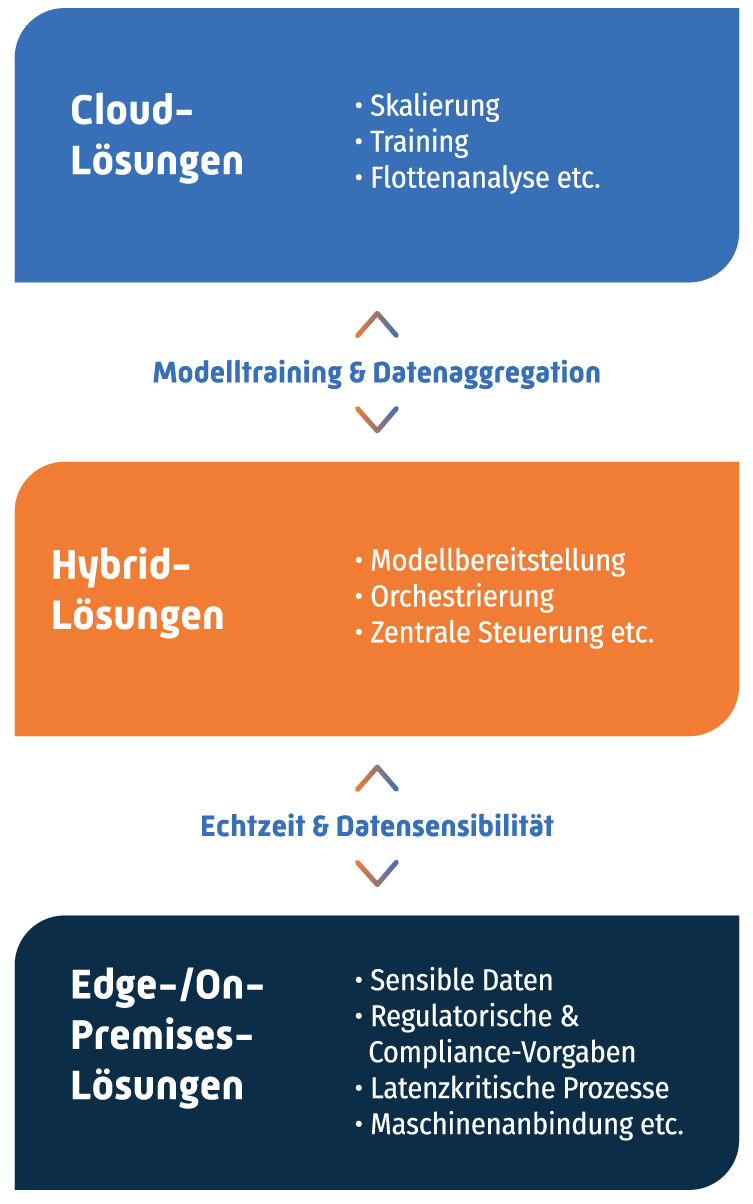

Anforderungen an zukunftsfähige KI-Infrastrukturen für Unternehmen

Testläufe zeigen immer wieder: Erst im Tagesgeschäft trennt sich die Spreu vom Weizen. Systeme müssen zuverlässig laufen, selbst wenn die Lasten schwanken oder Störungen auftreten. Damit das funktioniert, muss die Infrastruktur nicht nur schnell, sondern pragmatisch beherrschbar sein. Sechs Faktoren stechen dabei heraus:

- Rechenleistung im Alltag: Training ist selten das Problem

Training braucht kurzfristig Power, der Alltag dauerhafte Stabilität. Wenn Kapazitäten fehlen, stoppen Modelle mitten im Einsatz … und Prozesse gleich mit. Eine belastbare KI-Infrastruktur muss deshalb beides abdecken: Peaks im Projekt und Performance im Tagesgeschäft.

- Datenmanagement: Ohne eindeutige Quellen wird KI blind

Daten kommen in vielen Betrieben selten aus einem Guss. Unterschiedliche Formate, abweichende Aktualität, verschiedene Verantwortlichkeiten. Eine tragfähige Infrastruktur braucht deshalb klare Regeln: Wo liegen die Daten? Wer pflegt sie? Wie schnell müssen sie zur Verfügung stehen? Und wie bleiben sie geschützt?

-

Integration in ERP, CRM & Co.: der Anschluss an die Wertschöpfung

Erste Implementierungen laufen oft auf isolierten Plattformen. Im Ernstfall muss KI aber mitlaufen und nicht etwa nebenher. Schnittstellen und Datenflüsse entscheiden darüber, ob Ergebnisse wirklich im Prozess landen und nicht nur in PowerPoint-Folien.

- Orchestrierung: wenn automatische Skalierung den Unterschied macht Spätestens wenn KI-Anwendungen wachsen, braucht es eine automatisierte Steuerung. Container-Umgebungen wie Kubernetes sorgen dafür, dass Systeme Lastwechsel verkraften und Ausfälle nicht gleich Stillstände auslösen.

- Monitoring & Sicherheit: Was man nicht sieht, kann man nicht beherrschen

Im Routinebetrieb braucht es Transparenz: Wer greift zu? Wo hakt es? Welche Risiken steigen? Gerade in regulierten Branchen sind Protokolle, Alarmierungen und klare Freigabeprozesse Pflicht, damit aus einem kleinen Engpass kein Betriebsausfall wird.

- Wirtschaftlichkeit: Planbarkeit schlägt Überraschungen

Investitionen sollen sich rechnen. Entscheider wollen wissen, was eine zusätzliche KI-Nutzung morgen kostet. Ob Cloud oder eigene Hardware: Beide Modelle bieten für sich genommen selten die nötige Planbarkeit – vor allem, wenn Lasten schwanken oder neue Anwendungsfälle hinzukommen.

Rahmenbedingungen für Ihre Infrastrukturentscheidungen

Technik allein reicht nicht. Ob KI in der Praxis wirklich funktioniert, entscheidet sich anhand der Rahmenbedingungen vor Ort. Budgets sind begrenzt, Teams klein und Compliance-Vorgaben hoch. Deshalb dürfen Infrastrukturentscheidungen nicht nur technisch überzeugen. Nein, KI-Lösungen für Unternehmen müssen in erster Linie wirtschaftlich sinnvoll, langfristig planbar und regulatorisch abgesichert sein.

Regulatorische Anforderungen: Kontrolle ist kein „Nice to have“

DSGVO, EU-AI-Act und branchenspezifische Compliance-Regeln geben vor, wie Künstliche Intelligenz betrieben werden darf: nachvollziehbar, sicher und risikobewusst. Das betrifft insbesondere Datenflüsse, Verantwortlichkeiten und Prüfmechanismen. Wer die Architektur falsch auslegt, steht schnell vor kostspieligen Anpassungen oder muss die KI im Zweifel wieder ausschalten.

Realität gewachsener Strukturen: Sie bestimmen, was möglich ist

Viele IT-Landschaften sind über Jahre organisch gewachsen: Insellösungen, Mischbetrieb und knappe Kapazitäten. Neue Technologien sollen sich einfügen, ohne den laufenden Betrieb zu gefährden. Gleichzeitig muss jede Investition sitzen: Fehlentscheidungen wirken sich über viele Jahre auf Kosten, Sicherheit und Wettbewerbsfähigkeit aus.

Keine Einheitslösung: Warum hybride Ansätze oft überlegen sind

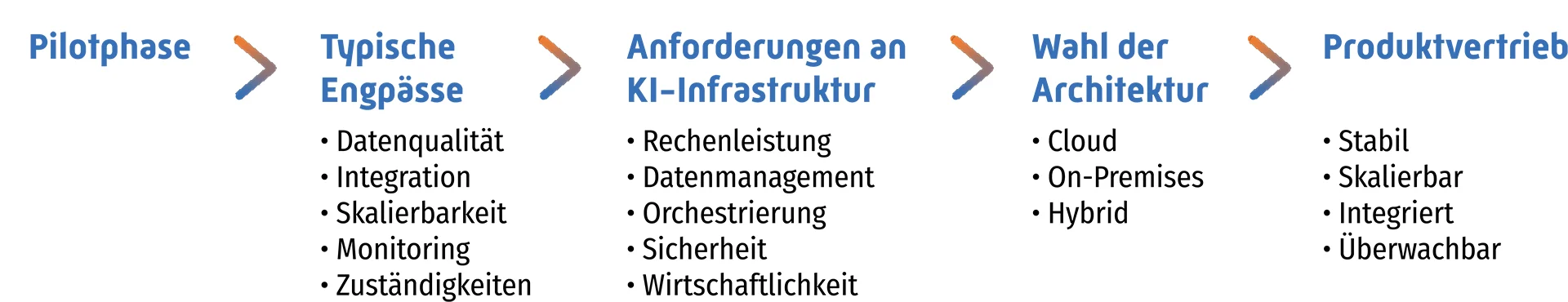

Unternehmen können KI‑Workloads grundsätzlich an drei Orten betreiben: in der Cloud, On‑Premises oder am Edge. Welche Kombination sinnvoll ist, hängt vom Einzelfall ab – von Datenanforderungen, Lastprofilen, Integration und Regulierung. Drei Entwicklungen zeigen, warum reine Einzelmodelle häufig an Grenzen stoßen:

- Wirtschaftliche Kipppunkte in der Cloud

Steigt die KI-Last stark an, steigen auch die variablen Cloud-Kosten deutlich – das zeigen viele Projekterfahrungen und Marktanalysen. Wer nicht gegensteuert, verliert Wirtschaftlichkeit. - Rechenleistung als Nadelöhr

Wenn KI‑Anwendungen wachsen, steigt der Bedarf an GPU‑Ressourcen schnell an. Fehlen Kapazitäten, werden Modelle langsamer, unzuverlässig oder teuer – und bremsen ganze Prozesse aus. - Regulierung verlangt Steuerbarkeit

Je sensibler die Daten, desto strenger die Anforderungen: Unternehmen müssen jederzeit nachvollziehen können, wo Modelle laufen, wer Zugriff hat und wie Entscheidungen zustande kommen. Das erfordert technische Kontrollmechanismen und klare Prozesse.

Die Folge: Hybride Modelle setzen sich durch. Sie verbinden Skalierbarkeit mit Planbarkeit und Kontrolle mit Flexibilität. Edge/On-Premises dort, wo es nötig ist, Cloud-Ressourcen dort, wo es sinnvoll ist. Genau diese Balance entscheidet in der Praxis darüber, ob KI echten Wert schafft oder im Status eines Prototyps stecken bleibt.

Cloud, On-Premises oder Hybrid: Welche Architektur für KI sinnvoll ist

Der Mittelstand steht an einem Wendepunkt: 40 % setzt KI bereits ein und rund ein Fünftel will KI demnächst einsetzen. Die Frage lautet also nicht mehr, ob die Infrastruktur geeignet ist, sondern wie sie aussehen muss.

Cloud? Lokal? Beides zusammen?

Die Antwort hängt von Daten, Lasten, Integration, Sicherheit und Kosten ab. Im Kern geht es darum, welche Architektur die Anforderungen des eigenen Betriebs zuverlässig trägt.

Cloud, Edge und On Premises arbeiten in einer hybriden Architektur zusammen.

Jede Ebene übernimmt die Aufgaben, für die sie am besten geeignet ist.

Daten: Sensibilität und Datenhoheit als Leitplanken

In jedem Unternehmen liegen besonders schützenswerte Informationen: von personenbezogenen Daten über interne Abläufe bis hin zu vertraulichem Know‑how. Bei solchen Daten spielt der Verarbeitungsort eine zentrale Rolle. Nicht alles darf in die Cloud. Manche Anwendungen gehören in eigene Rechenzentren oder regulierte Private-Cloud-Umgebungen.

Weil viele Unternehmen ihre Datenkategorien im Kontext neuer EU‑Regeln nicht eindeutig einordnen können, verfolgen sie häufig eine eher zurückhaltende Cloud‑Strategie. In zahlreichen Branchenbefragungen zeigt sich seit Jahren ein ähnliches Bild: Datenschutz, Datensouveränität und rechtliche Anforderungen gehören zu den wichtigsten Gründen für eine selektive oder hybride Cloud‑Nutzung.

Kurz gesagt: Ohne Vertrauen in die Datenwege lässt sich KI nicht zuverlässig einsetzen.

Praxisbeispiel „Possehl goes Europe“

Der Lübecker Technologiekonzern Possehl zeigt, wie sich Datenhoheit in einer regulierten Umgebung wahren lässt, ohne auf betriebliche Flexibilität zu verzichten. Kritische Daten verbleiben in den eigenen, kontrollierten IT-Umgebungen, wo sie nach internen Sicherheits- und Compliance‑Vorgaben verarbeitet werden. Für rechenintensive Aufgaben nutzt Possehl ergänzend europäische Cloud‑Ressourcen. So entsteht Flexibilität, ohne die Datenhoheit zu verlieren.

In der Praxis ergibt sich deshalb oft dieses Bild:

- Kritische Daten bleiben lokal im Unternehmen.

- Analyse und Lastspitzen laufen flexibel in der Cloud.

Das Ergebnis ist eine Architektur, die kritische Daten schützt und gleichzeitig skalierbare Ressourcen nutzbar macht.

Rechenlast: Was Training und Nutzung unterscheidet

Viele Unternehmen richten ihre KI-Architektur auf das einmalige Modelltraining aus. Doch dort liegt selten die Last. Der wahre Stresstest beginnt später im realen Einsatz: ununterbrochen, geschäftskritisch und mit stark schwankenden Anfragevolumina. Dann zeigt sich, ob die Infrastruktur mithält. Oder ob Prozesse ins Stocken geraten.

Das Beispiel zeigt, dass nicht das Training, sondern die laufende Inferenz den größten Teil der Rechenlast verursacht. REHAU Industries setzt KI zur visuellen Fehlererkennung in der Profilproduktion ein. Was in der Testphase noch zeitlich begrenzt lief, wird nun schrittweise in den Regelbetrieb überführt: mehrere Linien, kontinuierliche Analyse von Videodatenströmen und eine Infrastruktur, die auf Dauerlast und Skalierung ausgelegt ist. Damit wird deutlich, dass produktive KI-Anwendungen nur funktionieren, wenn die Infrastruktur auf hohe und schwankende Anfragevolumina vorbereitet ist.

Konsequenz für die Planung

Nicht das Training treibt Kosten und Architekturentscheidungen. Es ist der laufende Betrieb. Für Unternehmen bedeutet das: KI-Infrastrukturen müssen vor allem auf dauerhafte Last, Skalierung und schwankende Anfragevolumina ausgelegt sein. Genau hier spielen hybride Modelle ihre Stärke aus: flexibel in der Entwicklung, stabil und wirtschaftlich im Alltag.

Integration: KI muss mitten in die Wertschöpfung, nicht außen vor

Damit KI im Alltag zuverlässig unterstützt, muss sie in bestehende Abläufe und Systeme eingebettet sein. Entscheidend sind klare Datenflüsse, definierte Zuständigkeiten und kompatible technische Standards. Fehlen diese Grundlagen, bleibt das Potenzial der KI ungenutzt.

Wenn KI nicht nur ein Versprechen bleiben, sondern tatsächlich Prozesse stützen soll, dann müssen ein paar Dinge im Unternehmen geklärt sein:

- Wer verantwortet Betrieb, Monitoring und Updates?

- Wo laufen welche Services – Edge, On-Premises, Cloud?

- Wie schnell müssen Ergebnisse im Prozess ankommen?

Der Erfolg entscheidet sich genau an dieser Stelle: Integration ist nicht das Ziel am Ende, sondern der Start in den echten Betrieb.

Praxisbeispiel „Siemens und TRUMPF“: KI für die Fertigung wird anschlussfähig

In vielen Fertigungsumgebungen sind IT-Systeme und Maschinen noch nicht durchgängig verbunden. Das bremst Abläufe in der Produktion. Selbst dann, wenn KI-Anwendungen technisch bereits einsatzbereit sind. Siemens und TRUMPF arbeiten deshalb an offenen, interoperablen IT-Schnittstellen, um die Lücke zwischen Unternehmens-IT und Fertigungstechnik zu schließen. Durch diese standardisierten Verbindungen werden Datenflüsse besser nutzbar. So lassen sich KI-Analysen und -Entscheidungen direkt in Produktionsabläufen einsetzen.

Orchestrierung, Monitoring und Sicherheit: Was KI im Alltag wirklich braucht

In frühen Testphasen wirken KI-Anwendungen oft stabil, weil sie unter kontrollierten Bedingungen laufen. Im Regelbetrieb ist das anders: Automatisierung, Monitoring und klare Zuständigkeiten entscheiden über Stabilität und Verfügbarkeit. Analysen aus der industriellen Praxis zeigen, dass bis zu 80 % aller KI-Erprobungen nicht in den Dauerbetrieb übergehen. Und zwar nicht wegen der KI-Modelle, sondern weil Betriebsprozesse, Datenqualität, Betriebsstrukturen und klare Verantwortlichkeiten fehlen.

Die fünf zentralen Ebenen, die eine KI Lösung im Alltag betriebsfähig machen:

Orchestrierung: Skalierung ohne Stillstand

Wenn KI-Anwendungen wachsen, wird manuelles Steuern zum Risiko. Container-Plattformen wie Kubernetes sorgen dafür, dass:

- Workloads automatisch verteilt werden

- Systeme Lastwechsel verkraften

- Ausfälle keinen Produktionsstopp auslösen

Orchestrierung stellt damit sicher, dass KI‑Anwendungen auch bei wachsender Last stabil und verfügbar bleiben.

In geschäftsrelevanten Prozessen zählt jede Sekunde. Leistungswerte wie Fehlerquoten, Latenzen und die Auslastung der Ressourcen müssen jederzeit sichtbar sein. Nur so lassen sich Störungen erkennen, bevor sie den Betrieb beeinträchtigen. Monitoring ist deshalb kein optionaler IT-Zusatz, sondern betriebliche Pflicht.

Wirtschaftlichkeit: Kontrolle statt Kostenfalle

KI verändert nicht nur Prozesse, sondern auch Kostenstrukturen. Rechenlast, Datenvolumen und Verfügbarkeitsanforderungen steigen oft schneller als geplant. Damit KI im Alltag wirtschaftlich bleibt, braucht es klare Entscheidungen darüber, wo Anwendungen laufen, wie Ressourcen gesteuert werden und welche Abhängigkeiten akzeptabel sind. Wirtschaftlichkeit entsteht nicht durch das günstigste Modell, sondern durch Transparenz und Steuerbarkeit.

Kostenmechanismen bei KI‑Anwendungen unterscheiden sich deutlich von klassischen IT‑Systemen. Entscheidend sind Faktoren wie Datenmengen, Modellgrößen, Latenzanforderungen und Skalierungsbedarf. Diese Anforderungen zeigen, welches Betriebsmodell im jeweiligen Einsatz wirtschaftlich sinnvoll ist:

- Cloud: Diese Lösung ist für variable Lasten und schnelle Experimente geeignet. Wirtschaftlich, wenn Rechenbedarf schwankt oder kurzfristig steigt.

- On-Premises (lokal): Der lokale Betrieb ist bei stabilen, planbaren Lasten oder sensiblen Daten sinnvoll. Höhere Einstiegskosten, dafür langfristig gut kalkulierbar.

- Hybrid: Die hybride Lösung verbindet beide Ansätze. Kritische oder latenzsensitive Anwendungen laufen lokal, während skalierbare Teile flexibel in die Cloud ausweichen.

Abhängigkeiten vermeiden, Handlungsfähigkeit sichern

Abhängigkeiten von einzelnen Technologie- oder Cloud-Anbietern (Vendor-Lock-in) können teuer werden und strategisch riskant sein. Wer sich zu stark an einen Anbieter bindet, verliert Spielräume in puncto Kosten, Technologien und Weiterentwicklung. Hybride oder modular aufgebaute Architekturen halten Optionen offen und erleichtern Anpassungen, wenn Anforderungen oder Rahmenbedingungen sich ändern.

Die größten Kosten entstehen nicht in der Entwicklung, sondern im laufenden Betrieb. Wirtschaftlichkeit bedeutet deshalb, den Ressourceneinsatz kontinuierlich zu steuern und Transparenz zu schaffen. Dazu gehören:

- Ressourcenverbrauch sichtbar machen

- Lastspitzen automatisiert abfangen

- Unnötige Rechenlast vermeiden

- Modelle regelmäßig überprüfen und optimieren

Ein klar geregelter Betrieb verhindert, dass KI‑Anwendungen unbemerkt wachsen, ineffizient werden oder Kosten verursachen, die erst spät auffallen. Wirtschaftlichkeit entsteht damit nicht durch einmalige Entscheidungen, sondern durch einen kontinuierlich gesteuerten Betrieb.

Praxisbeispiel „TRUMPF“: hybride KI in der Produktion

Wie das in der Praxis aussieht, zeigt der Maschinenbauer TRUMPF. Das Unternehmen setzt in seiner Smart-Factory-Architektur auf ein hybrides KI-Modell:

- Latenz- und datensensitive Analysen laufen direkt an der Maschine über Edge-KI.

- Cloud-Dienste unterstützen Flottenanalysen, Modelltraining und Optimierungen.

So bleiben sensible Produktionsdaten lokal geschützt, während skalierbare Rechenleistung für komplexe KI-Modelle zur Verfügung steht. Das Ergebnis: KI‑Funktionen lassen sich bedarfsgerecht bereitstellen – effizient, kontrolliert und wirtschaftlich.

Hybride Modelle geben Unternehmen die Freiheit, Daten zu schützen, Kosten zu steuern und dennoch flexibel zu bleiben. Sie lösen zentrale Spannungsfelder im KI-Betrieb: sensible Daten können in kontrollierten Umgebungen verbleiben, während rechenintensive oder stark schwankende Workloads in die Cloud ausgelagert werden. So lassen sich Datenschutz, Latenzanforderungen und Skalierbarkeit je nach Anwendungsfall ausbalancieren. Entscheidend ist dabei nicht die Technologie allein, sondern wie gut die KI-Infrastruktur zur Realität mittelständischer Betriebe passt.

Was jetzt zählt: Die passende Infrastruktur für Ihre KI

Der Einstieg in verlässliche KI-Lösungen für Unternehmen beginnt mit einer nüchternen Bestandsaufnahme. Entscheidend ist, wie gut die vorhandene Infrastruktur die Anforderungen des Tagesgeschäfts unterstützt. Dazu gehören Fragen wie diese:

- Welche Daten gibt es und wie sensibel sind sie?

- Welche Systeme dürfen keinen Ausfall riskieren?

- Wie kritisch wirken sich Ausfälle oder Verzögerungen im Prozess aus?

- Welche Anforderungen bestehen an Stabilität, Geschwindigkeit und Support im Tagesgeschäft?

Auf dieser Grundlage lässt sich bestimmen, welches Betriebsmodell im jeweiligen Fall sinnvoll ist: lokal, in der Cloud oder im Zusammenspiel beider Ansätze. So entsteht eine Infrastruktur, die wirtschaftlich tragfähig ist und den operativen Alltag zuverlässig unterstützt.

Wenn Sie klären möchten, welche Infrastrukturvariante für Ihre KI-Anforderungen geeignet ist, unterstützen Sie unsere Expertinnen und Experten der pace-IT sehr gerne. Gemeinsam analysieren wir Ihre Ausgangslage und entwickeln einen umsetzbaren Plan für die nächsten Schritte.

Eine durchdachte KI-Infrastruktur verbindet Rechenleistung, Speicher, Plattformen und Sicherheitsanforderungen zu einer stabilen technischen Grundlage. pace-IT unterstützt Unternehmen dabei, diese Infrastruktur passgenau zu planen, aufzubauen und zu betreiben.

Mehr zum Thema KI-Infrastruktur